摘要:近10 年来,人工智能技术得到了科技与工业界的极大的重视,预示着人类文明将进入智能时代。但是,作为智能时代基础的“智能科学”还远未成型。本文从电磁物理信息感知技术的独特视角,讨论智能科学如何发展的一些见解,指出人类智能与外在世界互为对偶问题、相互不可分割的根本属性,因此按人工智能所应对的对象及关联学科分为数学、物理、心理、意识4 个阶段。其中第1 阶段解决智能形成的通用学习算法的数学理论,第2 阶段发展应对物理世界的物理智能。以此为基础,第3 阶段发展应对智能涉及社会群体的高阶智能,第4 阶段研究自由意识的本质和人工智能能否形成意识的超智能问题。结合笔者电磁信息感知专业领域,提出向物理智能发展的微波视觉新概念、相关内涵以及关键技术的建议,以笔者团队在这一方向的前期工作为例,讨论了以物理智能为基础的智能科学的研究与发展。

著名的摩尔定律成功预测了集成电路的指数次增长规律,实际上人类文明和科技的发展也大致遵循指数次增长的规律。如果把人类社会发展史绘制成一条曲线,横坐标为时间,纵坐标为文明和科技水平,那么它就是一条指数增长曲线。站在今天回望历史,不难发现人类每一次科技革命到来的时间间隔在指数次递减。例如40年前的个人计算机技术、100年前的相对论和量子力学、500年前的近代科学起源,又比如两次工业革命、农业革命、信息产业革命等,无不验证着这一规律。

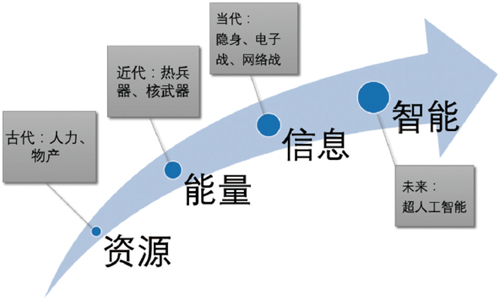

有人说人工智能是下一次工业革命,亦或许是人类文明的智能时代。科技是人类文明的核心之一,文明的进步经历了资源、能量、信息、智能的4个阶段(图1)。冷兵器时代人类文明依赖于自然资源的优势,热兵器时代的制胜点在于核武器等大规模杀伤性武器,进入信息时代后体现在信息获取能力上,发达国家依靠侦察、隐身、赛博等信息技术实现对其他国家的信息不对称性优势,可以预见未来决胜的是人工智能水平的高低。

信息时代的关键是全面多类精准信息快速获取和反获取的能力,包括军事科技的侦察、隐身、对抗等技术。在大数据获取能力达到一定的高度,必须由大数据的物理信息进一步进入到其物理世界背后的意识世界中,发展人工智能与超人工智能,实现对抗式的智能感知、处理、推演、决策技术,在未来智能科技时代占据领先优势。

图1 人类文明发展的新阶段

Fig. 1 New era of human civilization development

10 多年前神经网络研究先驱Hinton[1]在《Science》上发表的一篇论文在人工智能领域引发了深度学习热潮。谷歌子公司DeepMind开发的AlphaGo[2]以4∶1战胜了韩国围棋九段棋手李世乭,让人工智能得到了广泛的关注。人工智能在过去10年取得的重大进展,主要得益于深度学习技术,一种在强大的计算能力、海量的数据支持和改进的算法3个条件下成功实现突破的人工智能技术。

短短10年间,深度学习引发了人工智能在各行各业的研究应用热潮。在信息、生物、材料、化学等领域均开展了深度学习的人工智能应用研究。在工业界与政府部门,也纷纷推出重磅计划,为人工智能单设计划条目。深度学习技术在各领域均找到了应用,从而引起越来越多的关注。

然而,深度学习技术背后的理论积累难以支撑爆炸式增长的技术发展和应用需求。深度神经网络背后的理论基本上还是30多年前的人工神经网络理论,仅在深度表征和训练算法方面有局部突破。智能时代的来临亟需一门智能科学支撑。它与脑科学、认知科学等相关的诸多人脑功能学科相关联,又直接面对物理世界与社会科学界的应用需求。智能科学的举步维艰与人工智能技术应用的火爆现象的反差令人回想起前几次人工智能曾有过的寒冬。这种严峻的趋势也令多位著名学者进行深刻的思考。

本文简单讨论智能科学这一新学科方向,按人工智能所应对的对象及关联学科分为数学、物理、心理和意识4个阶段,并在物理智能的范畴下结合笔者前期研究提出信息感知的微波视觉新概念、相关内涵及关键技术。

1 智能科学

1.1 深度学习

深度学习属于机器学习,机器学习是人工智能的一个主要分支。深度学习的主要技术即深度神经网络,它是人工神经网络领域新兴的研究方向。人工神经网络通过将脑科学、数学、计算机科学、信息处理学、心理学等多个研究领域相互交叉结合,以建立一个可以模拟人脑智能的模型。虽然人脑智能研究仅有不到100年的发展历史,但已经在机器视觉、人脸识别、语音识别、智能搜索和遗传编程等领域得到了长足的发展,取得了广泛的十分有意义的应用。

人工神经网络研究起源于20世纪50年代,最早的人工神经网络模型只是对一个神经元接受刺激的响应进行简单的模拟。然而由于理论的缺乏和计算机技术的限制,人工神经网络并没能得到有效的发展。直到20世纪80年代,基于后向传播(BP)机制的神经网络得到快速发展。但是由于训练困难等问题,仍然局限于3层的神经网络,可以解决的问题很有限。之后,机器学习的主流方法大都是浅层结构算法(如支撑矢量机),少有人关注包含3层结构以上的深层算法。

2006年,Hinton[1]提出通过“贪婪学习”的思路,实现对多层自编码器的训练,重新引发了神经网络领域对于深层网络的研究兴趣。2012年,Hinton团队[9]将深度卷积网络用于ImageNet图像分类挑战赛上,取得远高于以往浅层算法的成绩,引起机器学习领域的关注。从此机器学习主流开始往多层自动学习算法偏移,超过3 层结构以上的机器学习算法被称为深度学习。2016年,谷歌子公司DeepMind将深度神经网络应用于强化学习上,开发了AlphaGo计算机围棋程序,4∶1击败了韩国围棋九段棋手李世乭,从而引发了各界人士的关注。各行各业对于人工智能的兴趣开始爆炸式增长。特别是在工业界,深度学习已被广泛的应用在各领域,如计算机视觉、语音识别、机器翻译、搜索引擎、自动驾驶、机器人等。

事实上,深度学习目前最成功的算法应该是深度卷积网络对于图像、视频类空域信息的处理,以及深度循环网络对于语音、文字类时间序列信息的处理[4]。例如深度强化学习的一些应用,均是得益于这2个核心神经网络算法对于原始输入数据的处理。而卷积神经网络与循环神经网络这两种网络结构早在20世纪90年代就被提出。可见深度神经网络或深度学习的核心在于“深度”,即用深层结构表征原始数据。

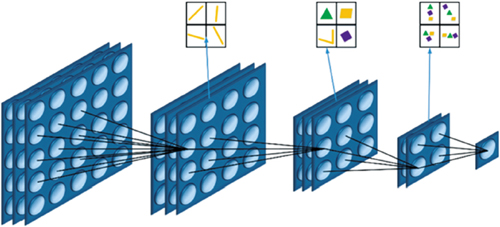

深度学习的核心思想是层次化的特征提取结构(图2),例如深度卷积网络仿照哺乳动物视觉神经系统,利用层次化特征提取的信息处理模式。先对输入信息进行低级特征提取,在高层将低级特征组合成更高级的特征信息,经过多层特征传递,得到足够高级的特征信息,再计算最终的输出。通过训练,从海量数据中自动提取所关心的特征,将数据标签映射拟合到一个高度非线性函数中。所以,深度神经网络的本质可以看作是一个多层嵌套的非线性拟合函数,它巧妙地通过随机梯度下降算法将网络训练到合适的拟合精度。然而,“深度”的概念也不是最新才提出的,用超过3层的多层神经网络来拟合的方法也早就被尝试过。因此学界普遍认为深度学习爆发与3个偶然因素有关:计算能力的指数次增长、数据量的爆炸式增长和神经网络算法的改进。这3个条件的成熟使得神经网络迈入了深度学习的阶段,因而能解决更接近实际应用的复杂问题。从这个角度看,深度学习的出现对于智能科学而言仅仅是量变,还没有达到质变。

图2 深度学习的主要思想:层次化可组合的特征表征框架

Fig. 2 Key idea of deep learning: hierarchical compositional framework of feature representation

回顾历史可以发现,21世纪初出现的计算能力的增长和数据量的增长使得训练深度神经网络成为可能,而算法的改进一直到近几年来才出现的。从2006年Hinton提出的多层自编码网络直到2012年的深度卷积网络之间并没有出现很成功的应用,而从2012年之后,视觉计算的最成功应用均采用深度卷积网络,说明深度神经网络的核心算法改进发生在2006—2012年。