导读:关于使用AI的许多论文的有效性或可靠性存在许多潜在问题,但目前尚不清楚基于AI的科学文献中的错误或不可靠的发现是否已经在实际临床实践中造成了真正的危险。科研人员表示:“很难避免我们可能在科学领域看到更多诚信问题的担忧”...

在2020年底的COVID-19大流行期间,一些国家的病毒感染检测试剂短缺。因此,利用一种已经广泛使用的医学技术——胸部X射线来诊断感染的想法听起来很吸引人。尽管人眼不能可靠地区分感染和非感染个体之间的差异,但印度的一个团队报告称,人工智能(AI)可以做到,利用机器学习分析一组X射线图像。[1]

这篇论文是关于这个想法的数十篇研究之一,已经被引用了900多次。但是到了次年的9月,堪萨斯州曼哈顿的计算机科学家Sanchari Dhar和Lior Shamir进行了更详细的研究。他们在相同的图像上训练了一个机器学习算法,但只使用了完全不显示任何身体部位的空白背景部分。然而,他们的人工智能仍然能够在远高于随机水平的情况下识别出COVID-19病例。[2]

问题似乎是医学图像数据集中医学图像的背景存在一致的差异。一个AI系统可以捕捉到这些伪像,从而在诊断任务中取得成功,而不需要学习任何临床相关的特征,使其在医学上毫无用处。

Shamir和Dhar发现了其他几种情况,其中据报告成功的AI图像分类(从细胞类型到面部识别)在图像的空白或无意义部分返回了类似的结果。这些算法在没有面孔的情况下更胜于随机地识别面孔,没有细胞的情况下更胜于随机地识别细胞。其中一些论文已被引用数百次。

Chest X-ray images of healthy people (left); those with COVID-19 (centre); and those with pneumonia (right).Credit: Healthy and Pneumonia: D. Kermany et al./Cell (CC BY 4.0); COVID-19: E. M. Edrada et al./Trop. Med. Health (CC BY 4.0).

Shamir表示,“这些例子可能很有趣”——但在生物医学领域,错误分类可能是生死攸关的问题。“这个问题非常普遍——比我大多数同行想要相信的要多得多。”2021年的一项独立回顾检查了62项使用机器学习从胸部X射线或计算机断层扫描中诊断COVID-19的研究,得出结论说,由于方法论缺陷或图像数据集中的偏见,其中没有一个AI模型在临床上是有用的。[3]

Shamir和Dhar发现的错误只是机器学习在研究中产生误导性声明的一些方式。普林斯顿大学新泽西分校的计算机科学家Sayash Kapoor和Arvind Narayanan今年早些时候报告说,数据泄漏问题(当用于训练AI系统的数据与用于测试它的数据之间没有足够的分离时)导致了他们检查的17个领域中的再现性问题,影响了数百篇论文。他们认为,对AI的不当应用正在导致再现性危机。[4]

机器学习(ML)和其他类型的人工智能是强大的统计工具,通过挖掘对人类研究人员通常是看不见的数据中的模式,几乎推动了科学的每个领域。与此同时,一些研究人员担心对AI软件的无知使用正在导致大量声称无法复制或在实际应用中是错误或无用的论文的涌现。

尽管还没有对这个问题的范围进行系统估计,但研究人员表示,从个例上看,充斥着错误的AI论文。“这是一个影响许多开始采用机器学习方法的社区的普遍问题,”Kapoor说。

佐治亚华盛顿大学的航空工程师Lorena Barba同意,几乎没有哪个领域能够幸免于这个问题。“我有信心地说,在物理科学的科学机器学习中存在普遍问题,”她说。“而且这不是关于大量质量差或影响力低的论文,”她补充说。“我读过很多发表在著名期刊和会议上的文章,与弱基线相比,夸大了论断,未能报告完整的计算成本,完全忽略了工作的限制,或以其他方式未能提供足够的信息、数据或代码来复制结果。”

“有一种正确的方式来应用ML来测试科学假设,许多科学家从未真正受到过适当的培训,因为这个领域仍然相对较新,”芝加哥德保罗大学的计算机方法在卫生研究中的专家Casey Bennett表示。“我看到很多常见的错误一遍又一遍地被重复,”他说。对于在健康研究中使用的ML工具,他补充说,“现在就像是荒野一样。”

AI是如何误入歧途的

与任何强大的新统计技术一样,AI系统使寻找特定结果的研究人员很容易欺骗自己。“AI提供了一个工具,允许研究人员‘玩弄’数据和参数,直到结果与期望一致,”Shamir说。

“AI的不可思议的灵活性和可调性,以及在开发这些模型时的不严谨性,提供了太多的自由度,”加拿大多伦多大学的计算机科学家Benjamin Haibe-Kains说,他的实验室将计算方法应用于癌症研究。

根据Kapoor和Narayanan提出的分类方法,数据泄漏似乎特别普遍。ML算法在数据中训练,直到它们可以可靠地为每个输入产生正确的输出,例如正确分类图像。然后,在未见过(测试)数据集上评估其性能。正如ML专家所知,必须保持训练集与测试集分开。但一些研究人员显然不知道如何确保这一点。

问题可能是微妙的:如果从与训练数据相同的池中取一个随机子集作为测试数据,这可能导致泄漏。如果来自同一患者(或同一科学仪器)的医学数据在训练集和测试集之间进行拆分,AI可能会学习识别与该患者或该仪器相关的特征,而不是特定的医学问题——例如在使用AI分析组织病理学图像时识别的问题。这就是为什么Shamir说,在图像的空白背景上进行“对照”试验是至关重要的,这能用于查看算法生成的结果是否合乎逻辑。[5]

Kapoor和Narayanan还提出了测试集不反映现实世界数据时的问题。在这种情况下,一种方法可能在其测试数据上给出可靠和有效的结果,但在现实世界中无法复制。

“真实世界比实验室中的变异要大得多,AI模型通常没有经过测试,以适应这种变异,直到我们部署它们,”Haibe-Kains说。

在一个例子中,谷歌健康团队在加利福尼亚州帕洛阿尔托的Google Health开发了一种AI,用于分析视网膜图像以检测糖尿病性视网膜病变的迹象,这可能导致失明。当Google Health团队的其他人在泰国的诊所中试用它时,由于该系统已经在高质量扫描上进行了培训,它拒绝了许多在次优条件下拍摄的图像。高拒绝率导致了与患者的更多随访面谈——这是一种不必要的工作负担。[6]

努力纠正训练或测试数据集可能导致自身的问题。如果数据不平衡——即不均匀地采样真实世界的分布——研究人员可能会应用重新平衡算法,如合成少数过采样技术(SMOTE),它会为欠采样区域生成合成数据。[7]

然而,Bennett表示,“在数据严重不平衡的情况下,SMOTE会导致对性能的过于乐观估计,因为你实质上是基于对底层数据分布的不可检验的假设创造了大量的‘假数据’”。换句话说,SMOTE实际上并没有平衡数据集,而是制造了充斥着与原始数据固有偏见相同的数据集。

即使是专家也很难避免这些问题。例如,2022年,法国数字科学和技术研究院(INRIA)的数据科学家Gaël Varoquaux及其同事在巴黎发起了一个国际挑战,要求团队开发能够从磁共振成像(MRI)获取的脑结构数据准确诊断自闭症谱系障碍的算法8。

该挑战吸引了来自61个团队的589份提交,而表现最佳的10个算法(主要使用ML)似乎在使用MRI数据时比使用基因型进行诊断的现有方法表现更好。但这些算法在另一个数据集上的推广能力较差,该数据集被保密,不向团队提供用于训练和测试模型的公共数据。研究人员写道:“对公共数据集的最佳预测过于美好,无法延伸到未见的私有数据集”。本质上,这是因为在小数据集上开发和测试方法,即使尽力避免数据泄漏,最终仍会过度拟合到这些数据,Varoquaux表示,即过于专注于与数据中的特定模式一致,以至于该方法失去了一般性。[8]

克服问题

今年8月,Kapoor、Narayanan和他们的同事提出了一种解决这个问题的方法,即制定了一个基于AI的科学报告的标准清单,其中包含32个问题,涉及数据质量、建模细节和数据泄漏风险等因素。他们表示,他们的清单“为ML-based科学的报告标准提供了跨学科的标杆”。其他清单已经为特定领域制定,如生命科学和化学。[9][10][11]

许多人认为,使用AI的研究论文应该完全公开其方法和数据。弗吉尼亚州分析公司Booz Allen Hamilton的数据科学家Edward Raff在2019年进行的一项研究发现,255篇使用AI方法的论文中只有63.5%能够按照报告的方式进行复制,但后来蒙特利尔麦吉尔大学的计算机科学家Joelle Pineau等人表示,如果原始作者通过积极提供数据和代码来帮助这些努力,复制率会提高到85%。考虑到这一点,Pineau和她的同事提出了一份使用AI方法的论文的协议,规定提交时必须包含源代码,并且必须根据标准的ML可重复性清单进行评估。[12][13]

但研究人员注意到,在任何计算科学中提供足够详细的信息以进行完全可重复性都是困难的,更不用说在AI中了。

而且,清单只能做到这么多。可重复性并不保证模型提供正确的结果,而只是保证自洽的结果,荷兰埃因霍温科技大学的计算机科学家Joaquin Vanschoren警告说。他还指出,“很多真正高影响的AI模型是由大公司创建的,他们很少立即公开他们的代码。”他说,有时人们不愿意发布自己的代码,因为他们认为还没有准备好接受公众的审查。

尽管一些计算机科学的会议要求提供代码才能发表同行评审的论文,但这并不是普遍的。Vanschoren表示,“最重要的会议对此更加认真,但这是一个复杂的问题。”

问题的部分原因可能是根本没有足够的数据可以正确测试模型。“如果没有足够的公共数据集,研究人员无法正确评估其模型,最终会发表显示出很好性能的低质量结果,”亚马逊AWS Health AI的科学家Joseph Cohen说,他还是美国非营利机构可重复研究研究所的主管。“这个问题在医学研究中非常严重。”

对于生成式AI系统(如大型语言模型(LLMs))来说,可能存在的风险更大,这些模型可以使用从其训练数据导出的模型生成新的数据,包括文本和图像。例如,研究人员可以使用这些算法提高图像的分辨率。但除非他们非常小心,否则可能会引入人为痕迹,谷歌位于加利福尼亚州山景城的研究科学家Viren Jain说,他致力于开发用于可视化和操作大数据集的AI。

“在显微镜领域,提高图像质量,如去除噪声,引起了很多兴趣,”他说。“但我不会说这些事情是百分之百可靠的,它们可能会引入人为痕迹。”他在自己研究大脑组织图像的工作中看到了这样的危险。“如果我们不小心采取适当的步骤来验证事物,我们可能很容易做出一些最终无意中导致不正确科学结论的事情。”

Jain还担心滥用生成式AI的可能性,作为创建看似真实的科学图像的一种简便方法。“很难避免我们可能在科学领域看到更多诚信问题的担忧,”他说。

文化转变

一些研究人员认为,只有通过改变有关数据呈现和报告的文化规范,问题才能真正得到解决。Haibe-Kains对于实现这样的变化并不太乐观。2020年,他和他的同事批评了一项关于ML检测乳腺癌的潜力的研究,该研究由Google Health的研究人员组成。Haibe-Kains及其合著者写道,“由于缺乏足够记录的方法和支持该研究的计算代码,该研究的科学价值受到了实质性的损害”,换句话说,由于没有足够的信息可以进行复制,该工作无法检查。[14][15]

该研究的作者在一份已发表的回应中表示,由于部分数据来自拥有隐私顾虑的美国医院,他们无权分享全部信息。他们补充说,他们“努力记录所有相关的机器学习方法,同时确保文章对临床和一般科学读者可见”。[16]

更广泛地说,Varoquaux和IT大学哥本哈根分校的计算机科学家Veronika Cheplygina认为,当前的出版激励机制,尤其是产生引人注目标题的压力,对基于人工智能的发现的可靠性构成了威胁。Haibe-Kains补充说,作者并不总是“本着善意的态度”遵守数据透明度准则,而期刊编辑在这方面通常没有足够的反击。[17]

Haibe-Kains认为问题不在于编辑放弃透明度的规则,而在于编辑和审稿人可能“对分享数据、代码等的真实和虚构障碍了解不足,因此他们往往满足于非常肤浅、不合理的理由 [不分享此类信息]”。实际上,作者可能并不了解确保其工作的可靠性和可重复性需要什么。Bennett表示:“如果你不完全理解自己在做什么,要做到完全透明是很困难的。”

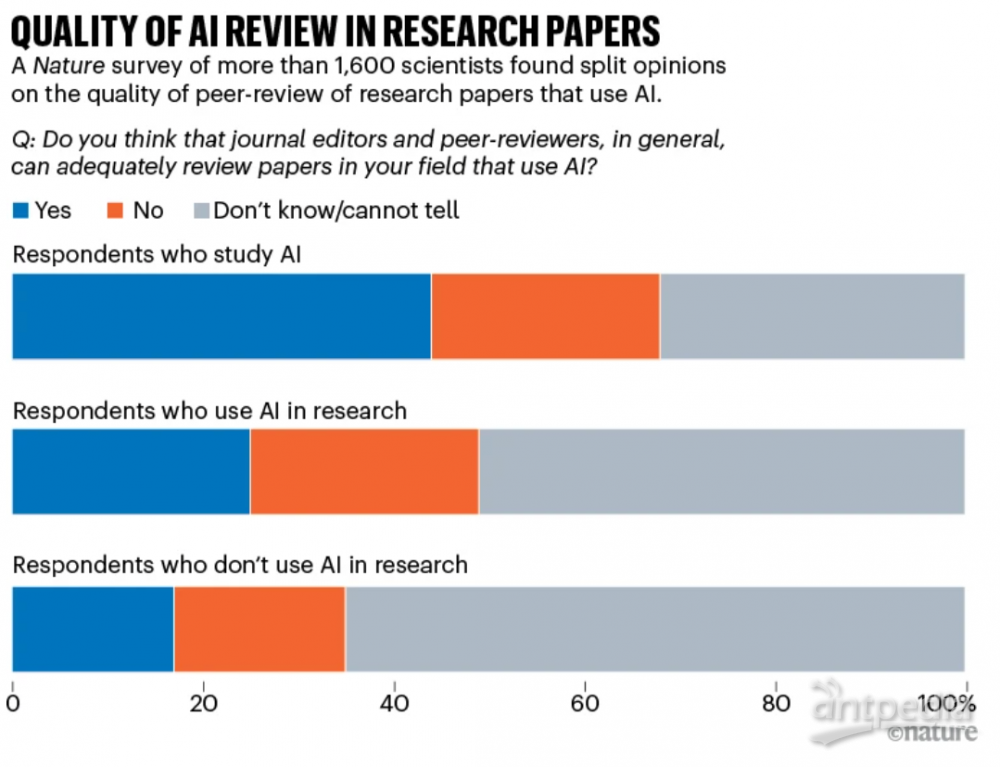

今年《自然》杂志进行的一项调查询问了1,600多名研究人员对于AI相关期刊文章的同行评审是否足够的看法。在那些使用AI进行工作的科学家中,有四分之一认为评论是足够的,四分之一认为不够,大约有一半表示不知道(见“研究论文中AI评论质量”和Nature 621, 672-675; 2023)。

Source: Nature 621, 672–675 (2023).

虽然有关个别论文存在大量潜在问题,但它们很少得到解决。个别案例往往陷入关于细节的争论和反驳。例如,在Kapoor和Narayanan调查的一些案例研究中,涉及使用ML预测内战爆发,他们声称结果被数据泄露扭曲的一些建议,得到了作者公开反驳(见Nature 608, 250–251; 2022)。而Dhar和Shamir批评的COVID-19胸部X射线识别研究的作者告诉《自然》杂志,他们不接受这些批评。

适应新的工具

并非每个人都认为人工智能危机正在逼近。“根据我的经验,我还没有看到人工智能应用导致无法重现结果增加的情况,”Helsinki Aiforia Technologies的神经科学家Lucas Stetzik说。事实上,他认为,经过谨慎应用,人工智能技术可以帮助消除常常渗透到研究人员工作中的认知偏见。“我之所以被吸引到人工智能领域,主要是因为我对许多方法无法重现以及一些不负责任的研究人员容易引导或挑拣结果的情况感到沮丧。”

尽管关于AI在科学文献中使用的许多发现的有效性或可靠性存在广泛的担忧,但目前尚不清楚基于AI的文献中的错误或不可靠的发现是否已经对例如临床实践中的误诊产生真正的危险。“我认为这有可能发生,我不会惊讶于发现它已经发生,但我还没有看到任何这样的报告,”Bennett说。

Cohen也认为问题可能会自行解决,就像其他新科学方法的初期问题一样。“我认为事情最终会自然而然地解决,”他说。“发表质量低的论文的作者将受到研究界的负面评价,不会得到未来的工作。发表这些论文的期刊将被视为不值得信赖的,好的作者将不希望在其中发表论文。”

加利福尼亚州门洛帕克生物信息公司Enable Medicine的生物工程师Alex Trevino表示,确保以跨学科团队的方式进行AI研究是使其更可靠的关键因素。例如,了解如何策划和处理数据集的计算机科学家应与了解数据获取的实验复杂性的生物学家合作。

Bennett认为,在未来十年或二十年,研究人员将更加深入地了解AI可以提供什么以及如何使用它,就像生物学家花了那么长时间才更好地了解如何将基因分析与复杂疾病联系起来一样。Jain表示,至少对于生成式人工智能,当使用的模型更加一致时,可重现性可能会得到改善。“人们越来越倾向于基础模型:像OpenAI的GPT-3和GPT-4这样可以执行许多任务的非常通用的模型,”他说。这更有可能产生可重现的结果,而不是一些在内部训练的定制模型。“因此,如果每个人都在使用相同的系统,你可以想象可重现性会有所提高。”

Vanschoren对航空航天工业进行了乐观的类比。“在早期,这是非常危险的,经过几十年的工程才使飞机变得值得信赖。”他认为人工智能将以类似的方式发展:“这个领域会变得更加成熟,随着时间的推移,我们将了解哪些系统是值得信赖的。”问题在于研究界是否能在此期间解决这些问题。

《自然》624, 22-25 (2023)

doi: https://doi.org/10.1038/d41586-023-03817-6

引用:

Philip Ball is a science writer in London.

1. Khan, A. I., Shah, J. L. & Bhat, M. M. Comput. Methods Prog. Biomed. 196, 105581 (2020).

2. Dhar, S. & Shamir, L. Vis. Inform. 5, 92–101 (2021).

3. Roberts, M et al. Nature Mach. Intell. 3, 199–217 (2021).

4. Kapoor, S. & Narayanan, A. Patterns 4, 100804 (2023).

5. Oner, M. U., Cheng, Y.-C., Lee, H.K. & Sung, W.-K. Preprint at medRxiv https://doi.org/10.1101/2020.04.23.20076406 (2020).

6. Beede, E. et al. in Proc. 2020 CHI Conf. Human Factors Comput. Syst. https://doi.org/10.1145/3313831.3376718 (2020).

7. Chawla, N. V., Bowyer, K. W., Hall, L. O. & Kegelmeyer, W. P. J. Artif. Intell. Res. 16, 321–357 (2002).

8. Traut, N. et al. NeuroImage 255, 119171 (2022).

9. Kapoor, S. et al. Preprint at https://arxiv.org/abs/2308.07832 (2023).

10. Heil, B. J. et al. Nature Methods 18, 1132–1135 (2021).

11. Artrith, N. et al. Nature Chem. 13, 505–508 (2021).

12. Raff, E. Preprint at https://arxiv.org/abs/1909.06674 (2019).

13. Pineau, J. et al. J. Mach. Learn. Res. 22, 7459–7478 (2021).

14. McKinney, S. M. et al. Nature 577, 89–94 (2020).

15. Haibe-Kains, B. et al. Nature 586, E14–E16 (2020).

16. McKinney, S. M. et al. Nature 586, E17–E18 (2020).

17. Varoquaux, G. & Cheplygina, V. npj Digit. Med. 5, 48 (2022).

![]()

Is AI leading to a reproducibility crisis in science(AI是否正在导致再现性危机).pdf

导读:关于使用AI的许多论文的有效性或可靠性存在许多潜在问题,但目前尚不清楚基于AI的科学文献中的错误或不可靠的发现是否已经在实际临床实践中造成了真正的......

导读:关于使用AI的许多论文的有效性或可靠性存在许多潜在问题,但目前尚不清楚基于AI的科学文献中的错误或不可靠的发现是否已经在实际临床实践中造成了真正的......

导读:关于使用AI的许多论文的有效性或可靠性存在许多潜在问题,但目前尚不清楚基于AI的科学文献中的错误或不可靠的发现是否已经在实际临床实践中造成了真正的......

导读:关于使用AI的许多论文的有效性或可靠性存在许多潜在问题,但目前尚不清楚基于AI的科学文献中的错误或不可靠的发现是否已经在实际临床实践中造成了真正的......

导读:关于使用AI的许多论文的有效性或可靠性存在许多潜在问题,但目前尚不清楚基于AI的科学文献中的错误或不可靠的发现是否已经在实际临床实践中造成了真正的......

导读:关于使用AI的许多论文的有效性或可靠性存在许多潜在问题,但目前尚不清楚基于AI的科学文献中的错误或不可靠的发现是否已经在实际临床实践中造成了真正的......

根据西班牙国家评估和认证机构(ANECA)的新提议,该国备受诟病的科学家评价体系将彻底改革。在旧体系中,学术职业发展的唯一评价标准是发表论文。据《科学》报道,上月宣布的这一改革举措提出,将首次评估西班......

ZYCGR22011901公共技术服务中心第一批科研仪器设备采购项目,总金额2275.87万元成交。详细信息如下:一、项目编号:OITC-G230291679(招标文件编号:OITC-G2302916......

近日,知乎知学堂联合电子工业出版社推出“对谈凯文·凯利——AI的过去、现在与未来”直播,邀请《连线》杂志创始主编凯文·凯利与知乎CTO李大海等人连线交流,探讨人工智能(AI)对当下的影响。面对AI技术......

近日,知乎知学堂联合电子工业出版社推出“对谈凯文·凯利——AI的过去、现在与未来”直播,邀请《连线》杂志创始主编凯文·凯利与知乎CTO李大海等人连线交流,探讨人工智能(AI)对当下的影响。面对AI技术......